Modele językowe rzadko robią błędy ortograficzne czy pomyłki w obliczeniach. Mogą jednak podawać Ci fałszywe, wymyślone informacje – i robić to z pełnym przekonaniem. To właśnie halucynacje.

Zdawanie sobie sprawy z możliwości ich występowania to absolutna konieczność, jeżeli pracujesz z AI. A jeszcze lepiej, jeśli wiesz, jak je rozpoznać i jak im zapobiegać. Właśnie o tym piszę poniżej.

Czym są halucynacje AI?

Halucynacje mają miejsce, gdy model językowy (jak ChatGPT czy Gemini) generuje odpowiedź, która jest gramatycznie poprawna i brzmi bardzo wiarygodnie, ale jest całkowicie zmyślona lub niezgodna z faktami.

Z jakimi rodzajami halucynacji możesz się spotkać?

- Halucynacje faktograficzne. AI może zmyślać daty, nazwiska, wydarzenia historyczne czy parametry techniczne.

- Halucynacje bibliograficzne. Model podaje tytuły książek, artykułów naukowych lub linki, które wyglądają na autentyczne, ale nigdy nie powstały.

- Halucynacje logiczne. AI poprawnie realizuje kilka kroków rozumowania, ale na końcu wyciąga całkowicie błędny, nielogiczny wniosek.

Dlaczego modele językowe halucynują?

Bo bazują na statystyce, a nie poszukiwaniu prawdy.

Model podczas treningu nie uczy się faktów, a jedynie tego, jakie słowo (token) powinno wystąpić jako następne. W efekcie potrafi świetnie odwzorować styl języka, ale nie zawsze potrafi odróżnić informacje prawdziwe od wymyślonych – zwłaszcza gdy dotyczą mniej popularnych zagadnień.

Jeśli zapytasz o coś bardzo rzadkiego lub nieistniejącego, istnieje ogromne prawdopodobieństwo, że model zamiast odpowiedzieć „nie wiem”, wybierze słowa, które statystycznie pasują do Twojego pytania. Sztuczna inteligencja nie myśli, a oblicza prawdopodobieństwo.

To nie jedyna przyczyna halucynacji.

Podczas Samsung AI Forum 2025 Yoshua Bengio zwracał uwagę, że współczesne modele są trenowane głównie po to, by brzmieć dobrze i zadowalać użytkownika, a niekoniecznie mówić prawdę.

To podejście sprzyja halucynacjom. Bengio podkreślał, że dopóki nagradzamy modele za przekonujący styl zamiast za weryfikowalne informacje, będą one skłonne zgadywać, żeby dobrze wypaść w naszych oczach.

Jak rozpoznać, że model AI halucynuje?

Modele AI nie skarjnie rzadko halucynują, gdy zapytasz je o proste fakty czy informacje, które bez problemu jesteś w stanie samodzielnie znaleźć w sieci. Problem zaczyna się wtedy, gdy pytasz o informacje rzadkie, niejednoznaczne albo trudne do sprawdzenia.

Może się tak zdarzyć np. gdy piszesz specjalistyczny artykuł – również wtedy, gdy prosisz o konkretne dane (model może je wymyślać!).

Oto sygnały alarmowe, które powinny zwrócić Twoją uwagę:

1. Dane i szczegóły idealnie dopasowane do Twoich pytań

AI rzadko przyznaje się do niewiedzy. Gdy nie zna odpowiedzi, może generować dane, które wyglądają na aż nazbyt precyzyjne.

Zwracaj uwagę na:

- Daty i liczby, których nie da się potwierdzić. Jeśli model podaje precyzyjny procent, rok albo liczbę użytkowników, zapytanie dotyczy niszowego tematu, a w Google nie ma o tym śladu, najprawdopodobniej masz do czynienia z halucynacją.

- Bibliografie, które brzmią wiarygodnie, ale nie istnieją. AI potrafi tworzyć tytuły książek, łączyć popularne nazwiska z losowymi słowami kluczowymi i podawać lata publikacji, które nigdy nie miały miejsca. Potrafi nawet podawać konkretne linki, które wywołują błąd 404. Zawsze sprawdzaj więc źródła – i w nie klikaj.

2. Różne odpowiedzi w różnych rozmowach

Modele potrafią brnąć w zaparte, nawet wtedy, gdy dopytujesz o szczegóły. To efekt tego, że starają się zachować spójność i zadowolić użytkownika.

Co możesz zrobić, by zweryfikować, czy model halucynuje?

- Otwórz nową sesję.

- Zadaj to samo pytanie, ale w innej formie.

- Porównaj odpowiedzi.

Jeśli odpowiedzi są sprzeczne lub znacząco różne, przynajmniej jedna z nich jest halucynacją.

3. Ogólnikowy język

W badaniach opublikowanych na łamach portalu Nature wykazano, że modele zaczynają halucynować, gdy zbliżają się do granicy swojej wiedzy. Znajduje to odzwierciedlenie w języku.

Oto, co powinno zwrócić Twoją uwagę:

- AI przechodzi na styl ogólnikowy.

- Pojawia się dużo przymiotników i pustych określeń: rewolucyjny, kluczowy, niezwykle ważny.

- W odpowiedzi brakuje twardych danych i konkretów.

4. Zbyt łatwe zgadzanie się z tezą użytkownika

Model AI rzadko wchodzi w otwarty spór z użytkownikiem. Jeśli zbyt szybko potwierdza kontrowersyjne lub nieoczywiste założenie, może to być sygnał, że nie weryfikuje informacji, tylko dopasowuje odpowiedź do oczekiwań.

Zwróć uwagę, jeśli model:

- bezrefleksyjnie potwierdza tezę, która powinna budzić wątpliwości,

- nie sygnalizuje niepewności ani ograniczeń swojej wiedzy,

- nie przedstawia alternatywnych interpretacji lub możliwych wyjątków.

5. Negatywna weryfikacja przez inverse prompting

Zamiast pytać model, czy na pewno ma rację, sprawdź, czy potrafi obalić własną odpowiedź.

Oto przykład, jak zastosować taką taktykę w praktyce:

- AI twierdzi, że strony cytowane w AI Overviews zawsze notują wzrost ruchu organicznego.

- Zapytaj: Dlaczego strony cytowane w AI Overviews nie zawsze notują wzrost ruchu organicznego?

Jeśli model natychmiast przechodzi na inną narrację i zaczyna uzasadniać przeciwieństwo własnej tezy, to wyraźny sygnał, że wcześniej zgadywał.

Czy sztuczna inteligencja zawsze może halucynować?

Tak, zawsze istnieje takie ryzyko.

Modele językowe nie korzystają z wiedzy w sposób, w jaki robi to człowiek lub klasyczna baza danych. Nie sprawdzają informacji w czasie rzeczywistym i nie sięgają do jednego, spójnego repozytorium faktów. Zamiast tego przewidują kolejne słowa na podstawie wzorców językowych, które poznały podczas treningu.

To ma kilka istotnych konsekwencji.

Po pierwsze, model zawsze próbuje Ci odpowiedzieć. Jeśli pytanie dotyczy niejednoznacznego, niszowego albo słabo udokumentowanego tematu, AI nie ma mechanizmu, który automatycznie zmusi ją do milczenia. Zamiast tego generuje odpowiedź, która brzmi wiarygodnie, nawet jeśli opiera się na niepełnych czy nawet fałszywych założeniach.

Po drugie, brak wiedzy nie zawsze jest sygnalizowany wprost. Model może nie wiedzieć, że czegoś nie wie. W efekcie potrafi łączyć prawdziwe elementy z domysłami, tworząc spójną narrację, która dopiero po weryfikacji okazuje się błędna.

Po trzecie, musisz liczyć się z tym, że im bardziej złożone pytanie, tym większe ryzyko halucynacji. Dotyczy to szczególnie:

- interpretacji danych,

- wniosków opartych na kilku przesłankach,

- tematów, w przypadku których nie istnieje jednoznaczna odpowiedź,

- informacji zmiennych w czasie (prawo, przepisy, dane rynkowe).

Jak zapobiegać halucynacjom?

Halucynacje da się ograniczyć – by to zrobić, nie możesz pozwolić modelowi zgadywać czy snuć domysłów.

Sztuczna inteligencja świetnie sobie radzi, kiedy pracuje na materiałach, które jej dostarczysz. Problemy zaczynają się wtedy, gdy zostawiasz ją samą sobie i oczekujesz, że będzie żonglować faktami, do których zwyczajnie nie ma dostępu.

Oto, jakie działania warto podjąć, by wyeliminować ryzyko halucynacji:

1. Technologia RAG

Istnieje jeden wyjątkowo skuteczny sposób zapobiegania halucynacjom – jest nim technologia RAG, czyli dostarczanie modelowi źródeł, na których ma pracować.

Możesz podać mu:

- fragment raportu,

- dane z arkusza,

- PDF,

- tekst artykułu,

- własne notatki.

Jeżeli chcesz tworzyć treści w oparciu o wyłącznie Twoje dane, dobrym pomysłem może okazać się skorzystanie z narzędzia Notebook LM. Bazuje ono wyłącznie na dostarczonych przez Ciebie plikach – ryzyko halucynacji więc nie występuje.

👉 Dowiedz się więcej o technologii RAG.

2. Optymalizacja promptów

Modele AI mają zakodowaną chęć pomocy. Musisz im więc wyraźnie pozwolić na wykazanie się niewiedzą.

Jak dokładnie to zrobić?

- Zawsze dodawaj do promptu zdania w stylu: Jeśli nie znajdziesz odpowiedzi w dostarczonych materiałach lub nie jesteś pewien faktów, napisz 'Nie wiem’. Nie próbuj zmyślać informacji.

- Proś model o przedstawienie swojego sposobu rozumowania. Wystarczy, że napiszesz: Wyjaśnij swój tok rozumowania krok po kroku przed podaniem ostatecznej odpowiedzi. Widząc proces myślowy, łatwiej wyłapiesz moment, w którym model odpływa.

3. Few-shot prompting

Few-shot prompting to technika, w której pokazujesz modelowi kilka przykładów, zanim poprosisz go o wykonanie właściwego zadania. Model nie musi wtedy zgadywać formatu ani stylu – trzyma się wzorca, który mu podasz.

Jak wykorzystać tę metodę w praktyce? Twórz prompty na zasadzie:

Sprawdź, czy w tekście znajdują się konkretne fakty. Jeśli nie – odpowiedz „brak informacji”.

Bazuj na przykładach:

Przykład 1

Tekst: „Projekt zakończono w czerwcu 2024.”

Czy podano datę zakończenia projektu?

Odpowiedź: „Tak – czerwiec 2024.”

Przykład 2

Tekst: „Projekt jest w trakcie realizacji.”

Czy podano datę zakończenia projektu?

Odpowiedź: „Brak informacji.”

Twoje zadanie:

Tekst: [Twoja treść]

Odpowiedź:

W ten sposób pokazujesz modelowi, że „brak informacji” to prawidłowa odpowiedź – a to jedna z najskuteczniejszych strategii przeciw halucynacjom.

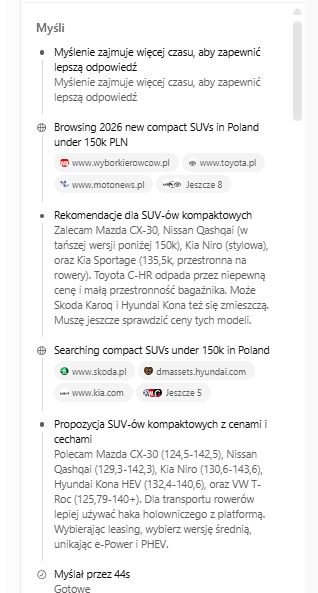

4. Podglądanie rozumowania AI

W niektórych modelach (np. Głębokie badania w GPT-5) możesz podejrzeć, jak sztuczna inteligencja doszła do swojej odpowiedzi. To bardzo skuteczny sposób na wyłapywanie halucynacji, bo widzisz nie tylko wynik, ale też tok rozumowania – czyli wnioski pośrednie, założenia i fragmenty, na których model opiera odpowiedź.

Jeśli w rozumowaniu pojawiają się fakty, których nie podałeś, albo skojarzenia, które nie mają żadnego uzasadnienia, to jasny sygnał, że model zaczął zgadywać.

5. Odpowiednie ustawienia temperatury

Temperatura to parametr, który kontroluje kreatywność modelu językowego. Określa, jak bardzo AI może odbiegać od najbardziej przewidywalnych odpowiedzi.

Szczegóły wyglądają następująco:

- Niska temperatura (0–0.3). Model wybiera najbardziej prawdopodobne słowa. Jest bardziej zachowawczy, mniej kreatywny – i znacznie rzadziej halucynuje.

Odpowiedzi są przewidywalne, czasem mało błyskotliwe, ale znacznie bardziej trzymają się faktów. - Średnia temperatura (0.4–0.7). Złoty środek. Model zachowuje spójność, ale ma przestrzeń na bardziej elastyczne formułowanie odpowiedzi.

- Wysoka temperatura (0.8–1.2). Model generuje bardziej kreatywne, swobodne odpowiedzi. W treściach opisowych to plus, ale w zadaniach wymagających szczegółów i precyzji, niemalże gwarancja większej liczby halucynacji.

W większości podstawowych narzędzi AI (jak ChatGPT czy Gemini w wersji webowej) nie możesz ustawić temperatury ręcznie. Możesz jednak skutecznie ją obniżyć za pomocą promptu.

Wystarczy dodać na początku polecenia krótką instrukcję, np.:

- „Odpowiadaj jak model o temperaturze 0.”

- „Podawaj tylko najbardziej prawdopodobne informacje. Zero kreatywności.”

- „Jeśli nie masz pewności – napisz nie wiem.”

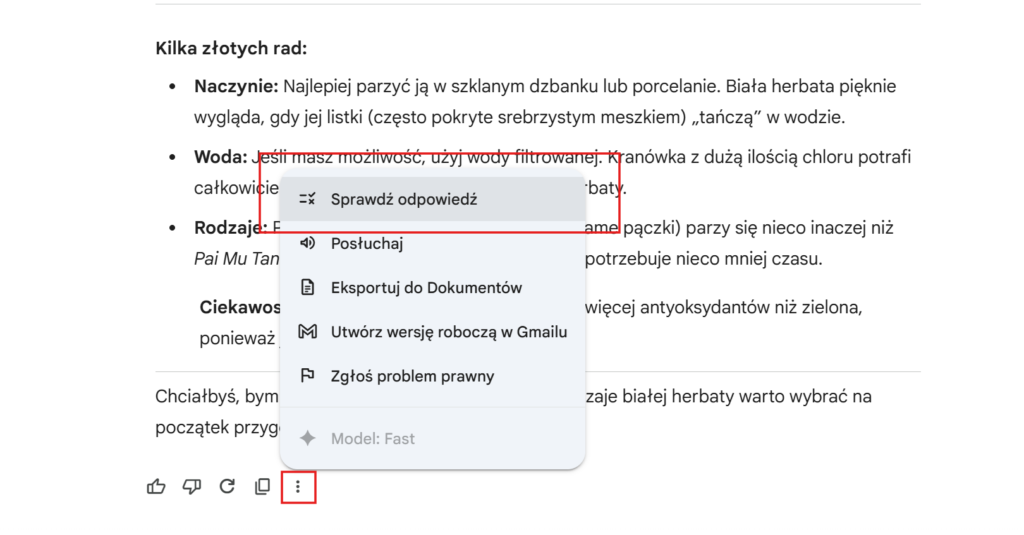

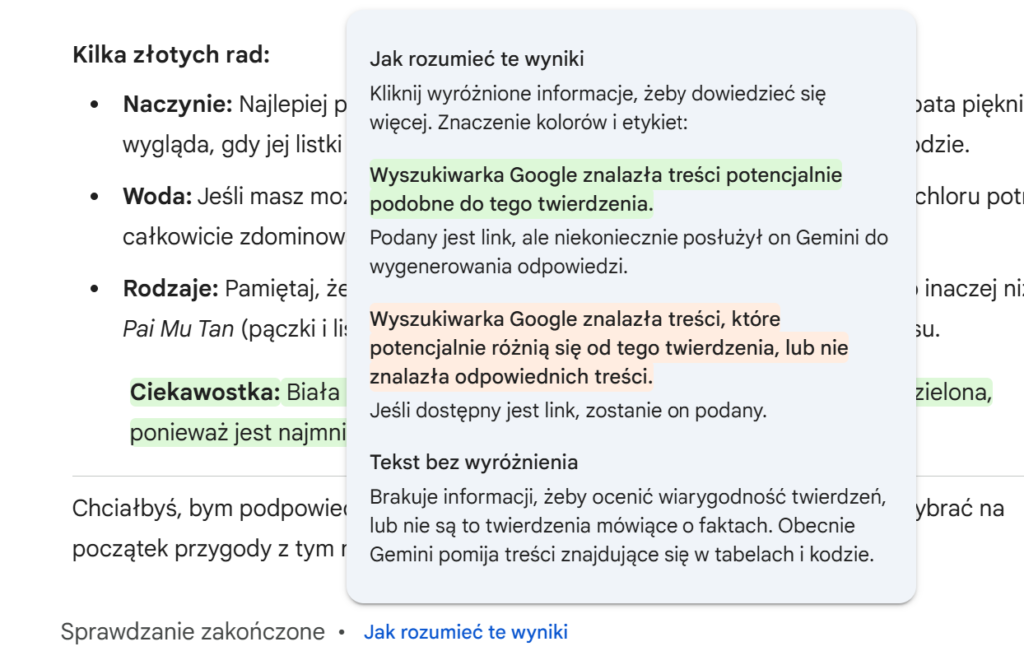

6. Korzystanie z funkcji narzędzi AI do weryfikacji

Taką możliwość daje Ci np. Gemini. Działa to w następujący sposób:

Model porówna swoje stwierdzenia z wynikami wyszukiwania i podświetli na zielono to, co znalazł w sieci, a na czerwono to, czego nie potrafi potwierdzić.

Podsumowanie

I don’t ask why patients lie. I just assume they all do.

To cytat z dr-a House’a, który świetnie ilustruje to, jak warto podchodzić do treści generowanych przez AI.

Nie traktuj halucynacji jako błędu systemu, który zaraz zniknie. Traktuj je jako stały element pracy z modelami językowymi.

Zasada ograniczonego zaufania ogromnie się tu przydaje. Staraj się ograniczać halucynacje tam, gdzie możesz i miej jednocześnie na uwadze, że AI to Twój asystent, a nie wyrocznia.

Katarzyna Kwartnik

Katarzyna Kwartnik