Analýza rozpočtu prehľadávania patrí medzi pracovné povinnosti každého odborníka na SEO (najmä ak sa zaoberá veľkými webovými stránkami). Ide o dôležitú úlohu, ktorá je slušne pokrytá v materiáloch poskytovaných spoločnosťou Google. Napriek tomu, ako môžete vidieť na Twitteri, dokonca aj zamestnanci spoločnosti Google bagatelizujú úlohu crawl budgetu pri získavaní lepšej návštevnosti a pozícií:

Majú v tomto prípade pravdu?

Hlavné závery

- Rozpočet na prehľadávanie je kľúčový pre SEO, predstavuje frekvenciu a počet adries URL, ktoré Googlebot môže indexovať počas jednej návštevy.

- Optimalizácia rozpočtu na prehľadávanie zahŕňa odstránenie chýb 404/410, zlepšenie rýchlosti stránky a zlepšenie interného prepojenia, čo môže Senuto Visibility Analysis pomôcť identifikovať.

- Externé crawlery, ako je Screaming Frog SEO Spider, sú užitočné na napodobnenie pohybov prehľadávacích robotov a poskytujú hlbší pohľad na údaje relevantné pre rozpočet na prehľadávanie.

- Google Search Console je neoceniteľný nástroj na analýzu limitu rýchlosti prehľadávania a na identifikáciu problémov s indexáciou, ktoré môžu ovplyvniť rozpočet na prehľadávanie.

- Optimalizácia sitemap.xml a analýza protokolov servera sú dôležité kroky na zabezpečenie, že Googlebot efektívne využíva pridelený rozpočet na prehľadávanie.

Ako funguje Google a ako zbiera údaje?“

Keď sme načali túto tému, pripomeňme si, ako vyhľadávač zhromažďuje, indexuje a organizuje informácie. Udržiavať tieto tri kroky v kútiku mysle je nevyhnutné počas neskoršej práce na webovej stránke:

Krok 1: Prehľadávanie. Prehľadávanie online zdrojov s cieľom objaviť – a prechádzať cez – všetky existujúce odkazy, súbory a údaje. Vo všeobecnosti Google začína s najpopulárnejšími miestami na webe a potom pokračuje v prehľadávaní ďalších, menej trendových zdrojov.

Krok 2: Indexovanie. Google sa snaží určiť, o čom stránka je a či analyzovaný obsah/dokument predstavuje jedinečný alebo duplicitný materiál. V tejto fáze Google zoskupuje obsah a stanovuje poradie dôležitosti (čítaním návrhov v rel=“canonical“ alebo rel=“alternate“ tagoch alebo inak).

Krok 3: Servírovanie. Po segmentácii a indexovaní sa údaje zobrazia ako odpoveď na dotazy používateľa. V tomto okamihu spoločnosť Google tiež údaje vhodne triedi, pričom zohľadňuje faktory, ako je napríklad poloha používateľa.

Dôležité: Mnohé z dostupných materiálov opomínajú krok 4: vytváranie obsahu. V predvolenom nastavení indexuje Googlebot textový obsah. Keďže sa však webové technológie neustále vyvíjajú, spoločnosť Google musela navrhnúť nové riešenia, aby prestala len „čítať“ a začala aj „vidieť“. Práve o tom je vykresľovanie. Slúži spoločnosti Google na podstatné zlepšenie dosahu medzi novo spustenými webovými stránkami a rozšírenie indexu.

Poznámka: Problémy s vykresľovaním obsahu môžu byť príčinou neúspešného rozpočtu na prehľadávanie.

Vyskúšajte Senuto Suite na 14 dní zadarmo

Vyskúšajte si 14-dňovú bezplatnú verziuČo je rozpočet na prehľadávanie?“

Rozpočet prehľadávania nie je nič iné ako frekvencia, s akou môžu prehľadávače a roboty vyhľadávačov indexovať vaše webové stránky, ako aj celkový počet adries URL, ku ktorým môžu pristupovať počas jedného prehľadávania. Predstavte si rozpočet na prehľadávanie ako kredity, ktoré môžete minúť v službe alebo aplikácii. Ak si nezabudnete „nabiť“ rozpočet na prehľadávanie, robot sa spomalí a bude vám venovať menej návštev.

V SEO sa „nabíjanie“ vzťahuje na prácu vynaloženú na získanie spätných odkazov alebo zlepšenie celkovej popularity webovej lokality. Z toho vyplýva, že rozpočet na prehľadávanie je neoddeliteľnou súčasťou celého ekosystému webu. Keď odvádzate dobrú prácu na obsahu a spätných odkazoch, zvyšujete limit dostupného rozpočtu na prehľadávanie.

Spoločnosť Google sa vo svojich zdrojoch neodvažuje explicitne definovať rozpočet na prehľadávanie. Namiesto toho poukazuje na dve základné zložky prehľadávania, ktoré ovplyvňujú dôkladnosť Googlebot a frekvenciu jeho návštev:

- .

- limit rýchlosti prehľadávania;

- dopyt po prehľadávaní.

Čo je to limit crawl rate a ako ho skontrolovať?“

Najjednoduchšie povedané, limit rýchlosti prehľadávania je počet súčasných spojení, ktoré môže robot Google vytvoriť pri prehľadávaní vášho webu. Keďže spoločnosť Google nechce poškodiť používateľský zážitok, obmedzuje počet spojení, aby zachovala plynulý výkon vašej webovej lokality/servera. Stručne povedané, čím pomalšia je vaša webová lokalita, tým menší je limit rýchlosti prehľadávania.

Dôležité: Limit prehľadávania závisí aj od celkového stavu SEO vašej webovej lokality – ak vaša lokalita vyvoláva veľa presmerovaní, chýb 404/410 alebo ak server často vracia stavový kód 500, počet spojení sa tiež zníži.

Údaje o limite počtu prehľadávaní môžete analyzovať pomocou informácií dostupných v konzole Google Search Console v správe Crawl Stats.

Dopyt po prehľadávaní alebo popularita webových stránok

Zatiaľ čo limit rýchlosti prehľadávania vyžaduje, aby ste vypilovali technické detaily svojej webovej stránky, dopyt po prehľadávaní vás odmeňuje za popularitu webovej stránky. Zhruba povedané, čím väčší rozruch je okolo vašej webovej lokality (a na nej), tým väčší je jej crawl demand.

V tomto prípade spoločnosť Google zohľadňuje dve záležitosti:

- Všeobecná popularita – Google ochotnejšie vykonáva časté prehľadávanie adries URL, ktoré sú na internete všeobecne populárne (nie nevyhnutne tých, na ktoré vedú spätné odkazy z najväčšieho počtu adries URL).

- Čerstvosť údajov indexu – Google sa snaží prezentovať len najnovšie informácie. Dôležité: Vytváranie stále nového obsahu neznamená, že sa zvyšuje celkový limit rozpočtu na prehľadávanie.

Faktory ovplyvňujúce rozpočet na prehľadávanie

V predchádzajúcej časti sme definovali rozpočet prehľadávania ako kombináciu limitu rýchlosti prehľadávania a dopytu po prehľadávaní. Majte na pamäti, že na zabezpečenie správneho prehľadávania (a tým aj indexovania) vašej webovej lokality sa musíte starať o obidva tieto faktory súčasne.

Nižšie nájdete jednoduchý zoznam bodov, ktoré je potrebné zohľadniť pri optimalizácii rozpočtu na prehľadávanie

- Server – hlavnou otázkou je výkon. Čím nižšia je rýchlosť, tým vyššie je riziko, že Google pridelí menej prostriedkov na indexovanie vášho nového obsahu.

- Kódy odpovedí servera – čím väčší počet presmerovaní 301 a chýb 404/410 na vašej webovej lokalite, tým horšie výsledky indexovania dosiahnete. Dôležité: Dávajte si pozor na slučky presmerovania – každý „skok“ znižuje limit rýchlosti prehľadávania vašej webovej lokality pri ďalšej návšteve bota.

- Bloky v súbore robots.txt – ak vychádzate zo smerníc robots.txt na základe vnútorného pocitu, môžete nakoniec vytvoriť úzke miesta indexovania. Výsledok: vyčistíte index, ale na úkor efektivity indexovania nových stránok (keď boli blokované adresy URL pevne zakotvené v štruktúre celého webu).

- Navigácia s aspektmi / identifikátory relácie / akékoľvek parametre v adresách URL – predovšetkým si dávajte pozor na situácie, keď sa adresa s jedným parametrom môže ďalej parametrizovať, pričom nie sú zavedené žiadne obmedzenia. Ak by sa tak stalo, Google sa dostane k nekonečnému počtu adries a všetky dostupné zdroje minie na menej významné časti našej webovej stránky.

- Duplicitný obsah – skopírovaný obsah (okrem kanibalizácie) výrazne poškodzuje účinnosť indexovania nového obsahu.

- Tenký obsah – ktorý vzniká, keď má stránka veľmi nízky pomer textu k HTML. V dôsledku toho môže Google stránku identifikovať ako takzvanú Soft 404 a obmedziť indexáciu jej obsahu (aj keď je obsah zmysluplný, čo môže byť napríklad prípad stránky výrobcu prezentujúceho jediný produkt a bez jedinečného textového obsahu).

- Špatné interné prepojenie alebo jeho nedostatok.

Užitočné nástroje na analýzu rozpočtu prechádzania

Keďže pre rozpočet na prehľadávanie neexistuje žiadne kritérium (čo znamená, že je ťažké porovnávať limity medzi webovými stránkami), vybavte sa súborom nástrojov určených na uľahčenie zberu a analýzy údajov.

Google Search Console

GSC sa v priebehu rokov pekne rozrástla. Počas analýzy rozpočtu na prehľadávanie by sme sa mali pozrieť na dve hlavné správy: Pokrytie indexu a Štatistiky prehľadávania.

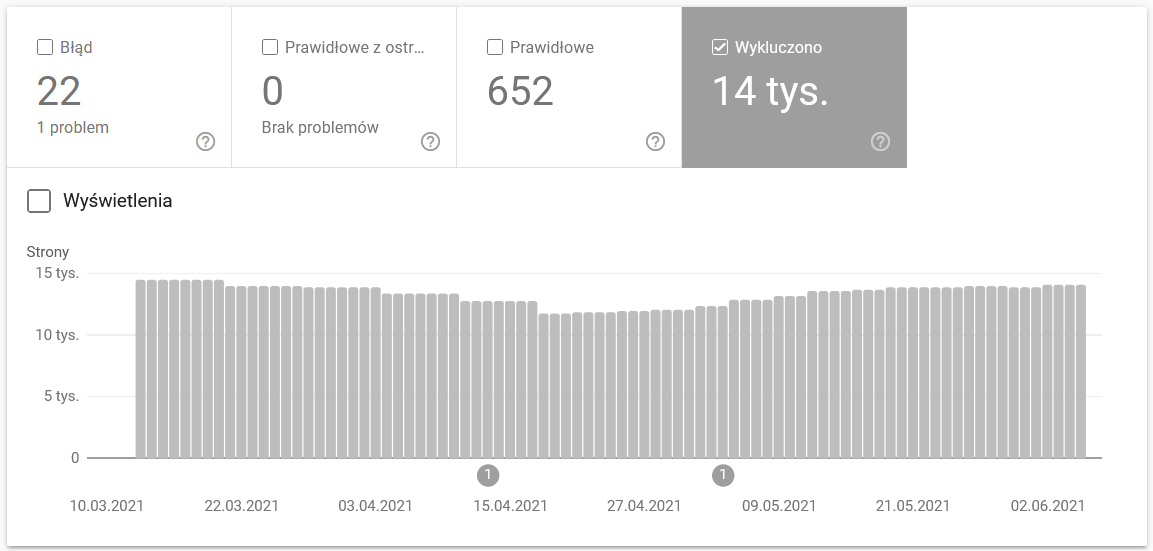

Pokrytie indexov v GSC

Táto správa je obrovským zdrojom údajov. Skontrolujme informácie o adresách URL vylúčených z indexovania. Je to skvelý spôsob, ako pochopiť rozsah problému, ktorému čelíte.

Celé správy si zaslúžia samostatný článok, preto sa teraz zamerajme na nasledujúce informácie:

- Vylúčené pomocou značky ‚noindex‘ – Vo všeobecnosti platí, že viac stránok bez indexu znamená nižšiu návštevnosť. Čo vyvoláva otázku – aký zmysel má ich udržiavanie na webovej lokalite? Ako obmedziť prístup k týmto stránkam?

- Prečítané – momentálne neindexované – ak to vidíte, skontrolujte, či sa obsah správne vykresľuje v očiach Googlebota. Nezabudnite, že každá adresa URL s týmto stavom plytvá vaším rozpočtom na prehľadávanie, pretože negeneruje organickú návštevnosť.

- Objavená – momentálne nie je indexovaná – jeden z alarmujúcejších problémov, ktorý sa oplatí zaradiť na prvé miesto v zozname priorít.

- Duplicitné bez používateľom zvoleného kanonického kódu – všetky duplicitné stránky sú mimoriadne nebezpečné, pretože nielenže poškodzujú váš rozpočet na prehľadávanie, ale zvyšujú aj riziko kanibalizácie.

- Duplikát, Google zvolil iný kanonický kód ako používateľ – teoreticky sa nemusíte obávať. Google by mal byť predsa dostatočne inteligentný na to, aby urobil správne rozhodnutie namiesto nás. No v skutočnosti Google vyberá svoje kanonické kódy celkom náhodne – často odrezáva cenné stránky s kanonickým kódom smerujúcim na domovskú stránku.

- Mäkká chyba 404 – všetky „mäkké“ chyby sú veľmi nebezpečné, pretože môžu viesť k odstráneniu kritických stránok z indexu.

- Duplikát, odoslaná adresa URL nebola vybraná ako kanonická – podobne ako pri hlásení stavu o nedostatku kanonických adries vybraných používateľom.

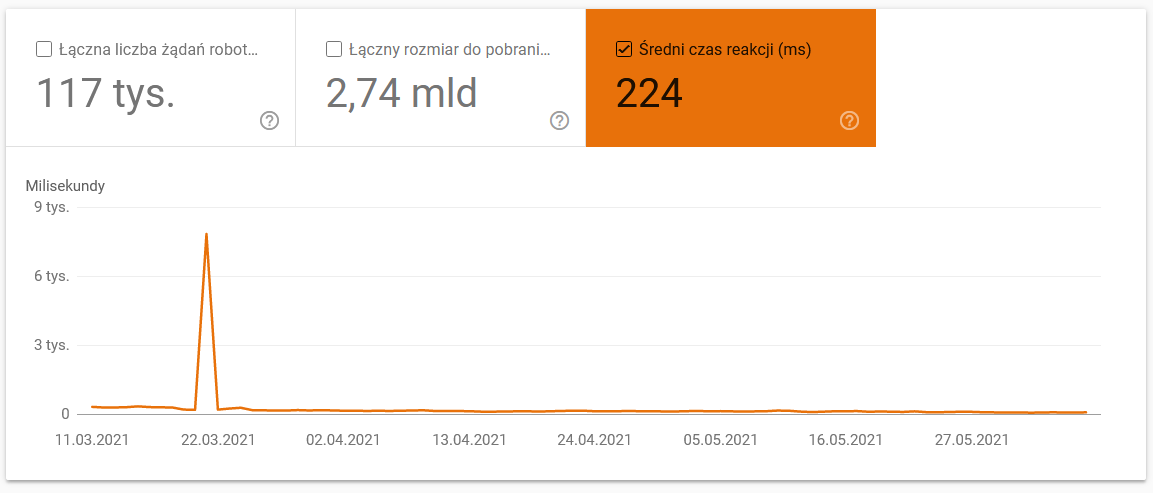

Statistika prehľadávania

Report nie je dokonalý a čo sa týka odporúčaní, dôrazne odporúčam pohrať sa aj so starými dobrými serverovými logmi, ktoré poskytujú hlbší pohľad na údaje (a viac možností modelovania).

Ako som už povedal, pre vyššie uvedené údaje budete ťažko hľadať referenčné hodnoty. Je to však dobrá výzva, aby ste sa na ne pozreli bližšie:

- Priemerný čas sťahovania. Nižšie uvedený snímok obrazovky ukazuje, že priemerný čas odozvy zaznamenal dramatický zásah, ktorý bol spôsobený problémami súvisiacimi so serverom:

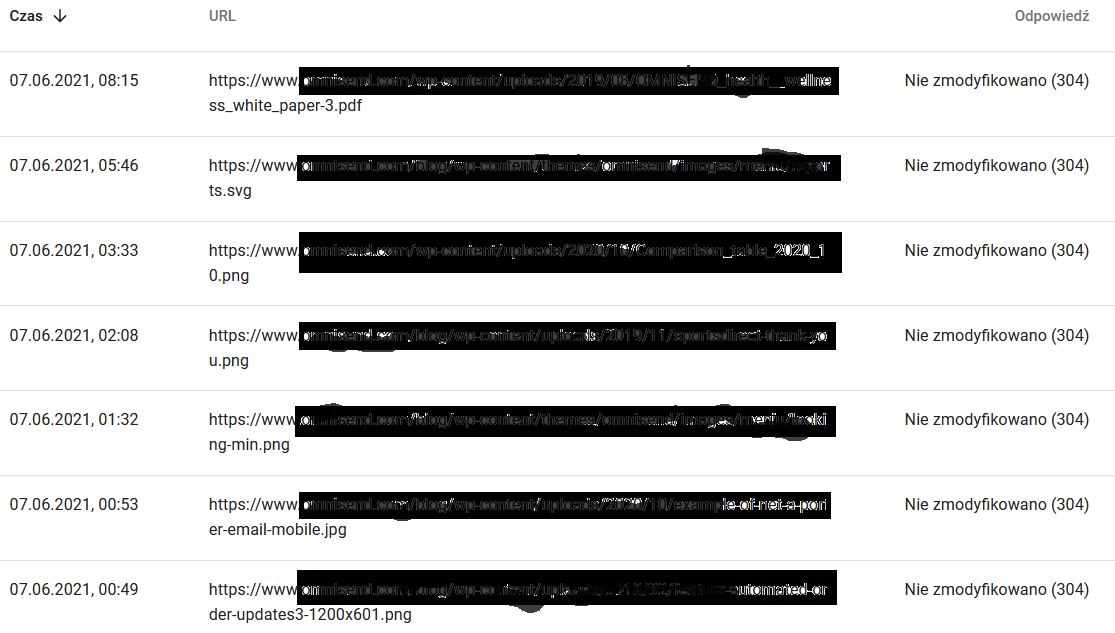

- Odpovede na prehľadávanie. Pozrite si správu, aby ste vo všeobecnosti zistili, či máte s webovou stránkou problém alebo nie. Venujte zvýšenú pozornosť atypickým stavovým kódom servera, ako je napríklad kód 304 uvedený nižšie. Tieto adresy URL neslúžia žiadnemu funkčnému účelu, napriek tomu Google plytvá svojimi zdrojmi na prehľadávanie ich obsahu.

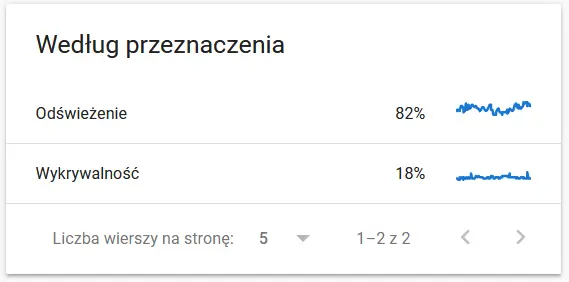

- Cieľ prehľadávania. Vo všeobecnosti tieto údaje do veľkej miery závisia od objemu nového obsahu na webovej lokalite. Rozdiely medzi informáciami zhromaždenými spoločnosťou Google a používateľom môžu byť celkom fascinujúce:

Obsah opätovne prehľadávanej adresy URL v očiach spoločnosti Google:

Medzitým tu vidí používateľ v prehliadači:

Určite dôvod na zamyslenie a analýzu : )

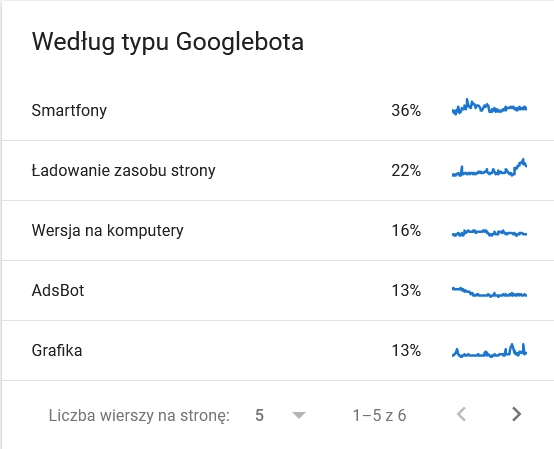

- Typ Googlebot. Tu máte na striebornom podnose botov, ktorí navštevujú vašu webovú stránku, spolu s ich motiváciou analyzovať váš obsah. Na nasledujúcom obrázku je vidieť, že 22 % požiadaviek sa týka načítania zdrojov stránky.

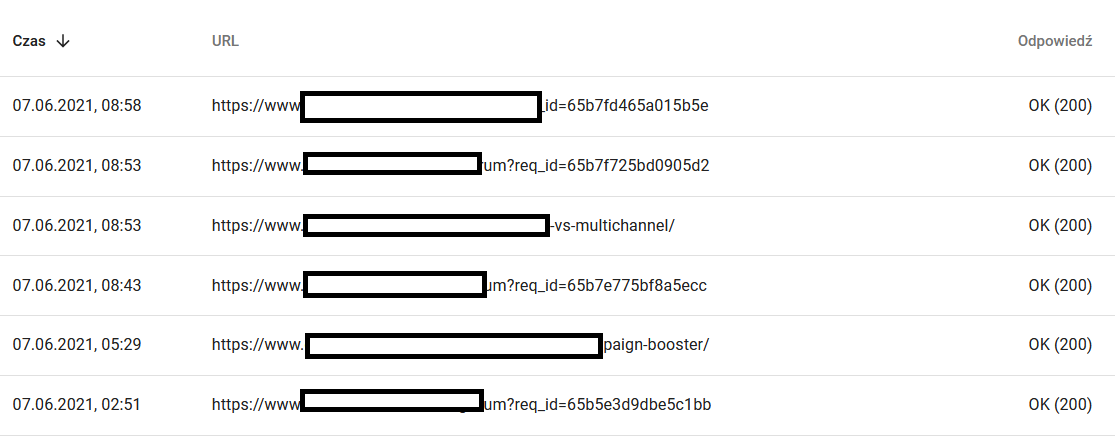

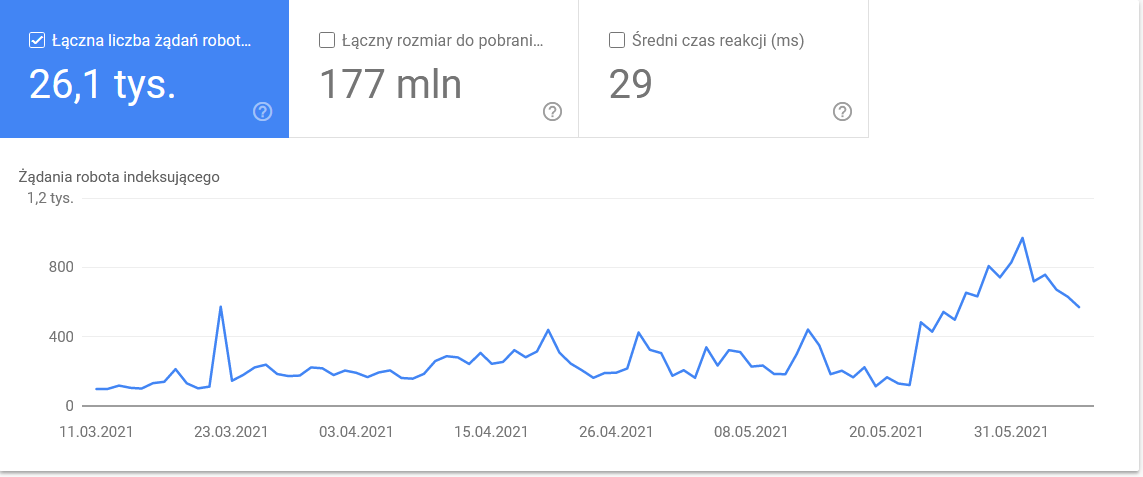

Celková suma sa v posledných dňoch časového rámca nafúkla:

Pri pohľade na detaily sa ukážu adresy URL, ktoré si vyžadujú väčšiu pozornosť:

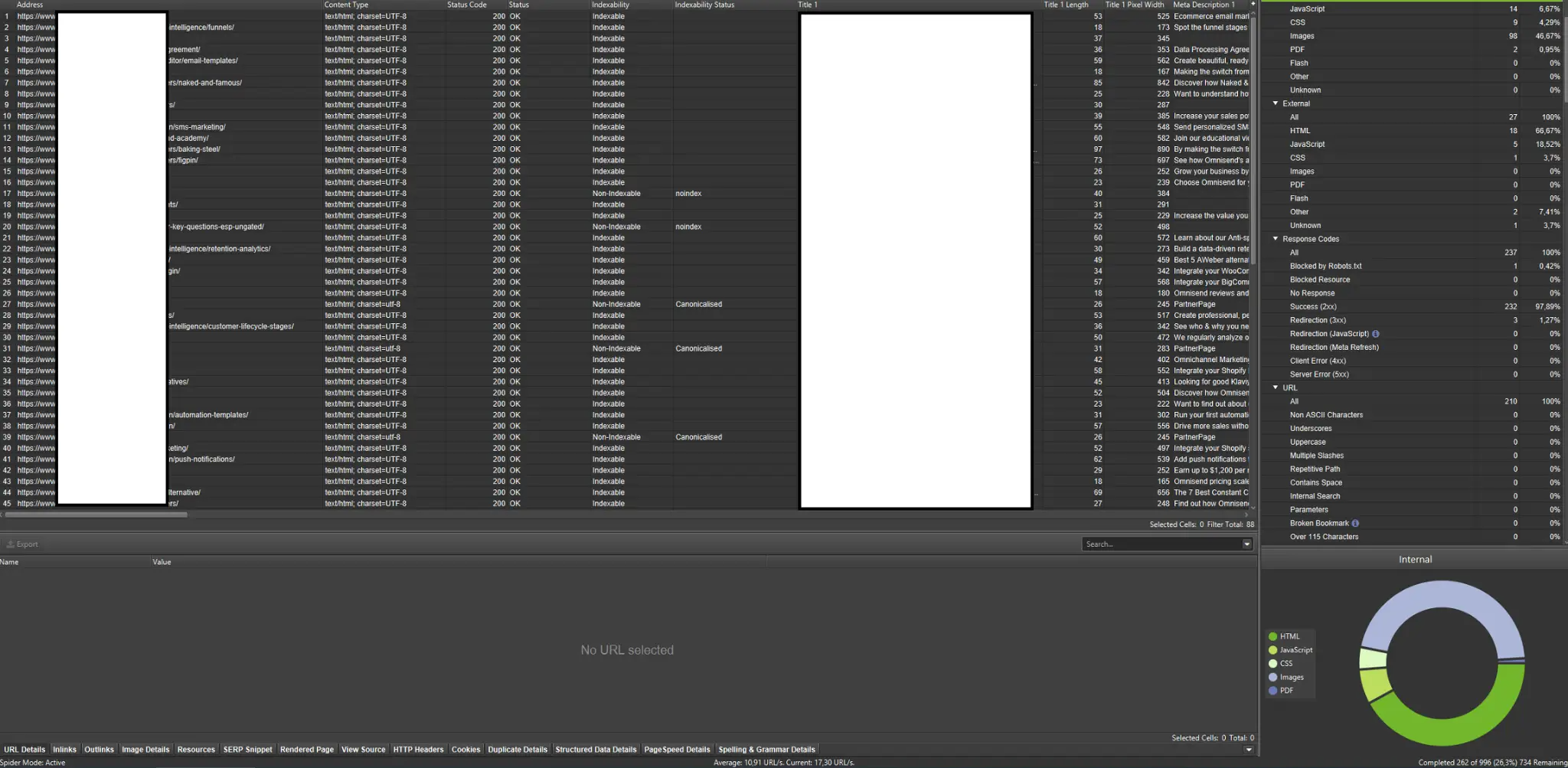

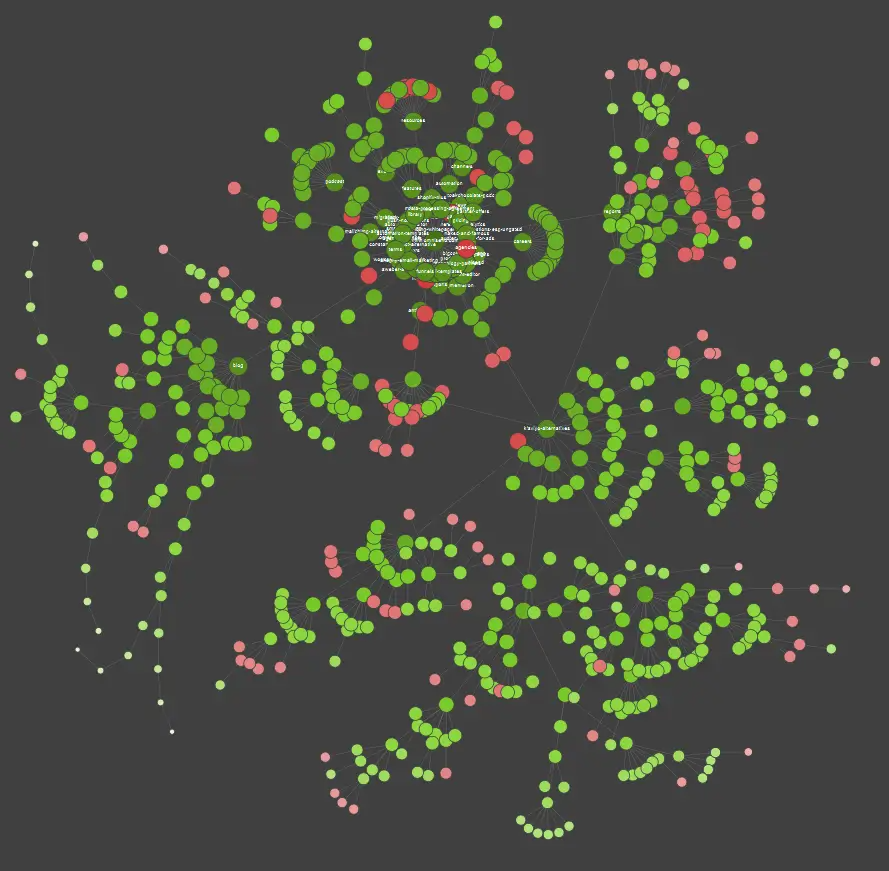

Externé crawlery (s_príkladmi z_spidera Screaming Frog SEO)

Crawlery patria medzi najdôležitejšie nástroje na analýzu rozpočtu na prehľadávanie webových stránok. Ich hlavným účelom je napodobňovať pohyby prehľadávacích botov na webovej lokalite. Simulácia vám na prvý pohľad ukáže, či všetko prebieha hladko.

Ak ste vizuálny študent, mali by ste vedieť, že väčšina riešení dostupných na trhu ponúka vizualizácie údajov.

Vo vyššie uvedenom príklade červené bodky označujú neindexované stránky. Chvíľu zvážte ich užitočnosť a vplyv na fungovanie webu. Ak protokoly servera odhalia, že tieto stránky strácajú veľa času spoločnosti Google a zároveň neprinášajú žiadnu pridanú hodnotu – je čas vážne prehodnotiť zmysel ich ponechania na webovej lokalite.

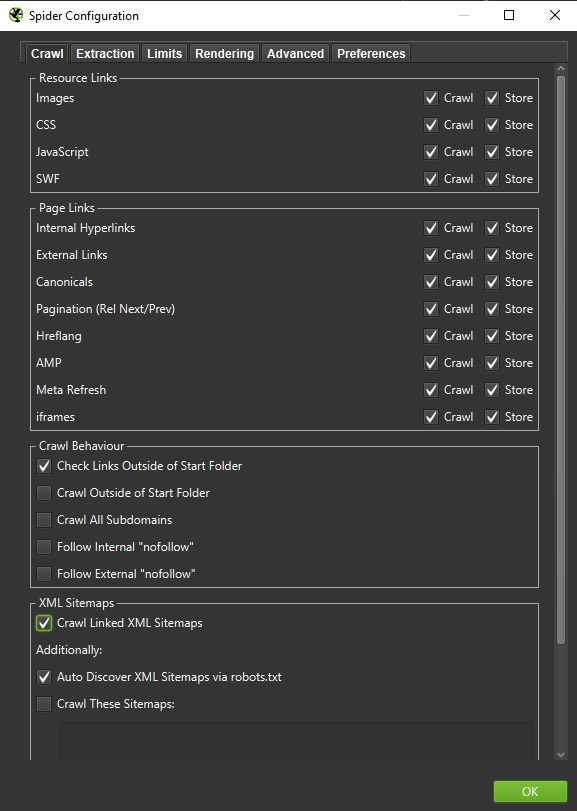

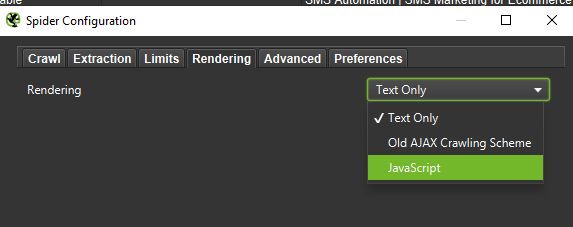

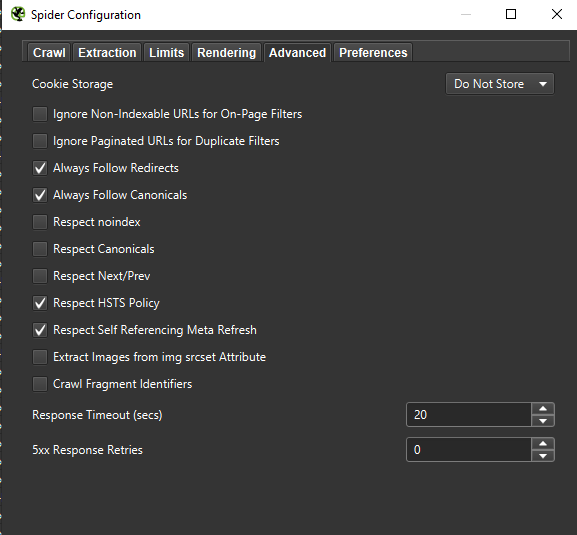

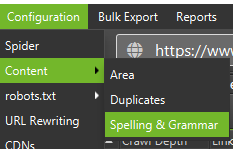

Dôležité: Ak chceme čo najpresnejšie zrekonštruovať správanie Googlebota, správne nastavenia sú nevyhnutnosťou. Tu si môžete pozrieť vzorové nastavenia z môjho počítača:

Pri hĺbkovej analýze je vhodné otestovať dva režimy – iba text, ale aj JavaScript – a porovnať rozdiely (ak nejaké sú).

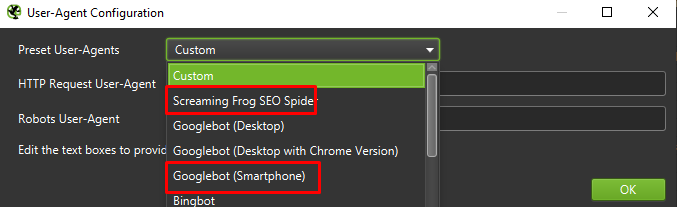

Nakoniec nikdy nezaškodí otestovať vyššie uvedené nastavenie na dvoch rôznych používateľských agentoch:

Vo väčšine prípadov sa budete musieť sústrediť len na výsledky prehľadávané/vykresľované mobilným agentom.

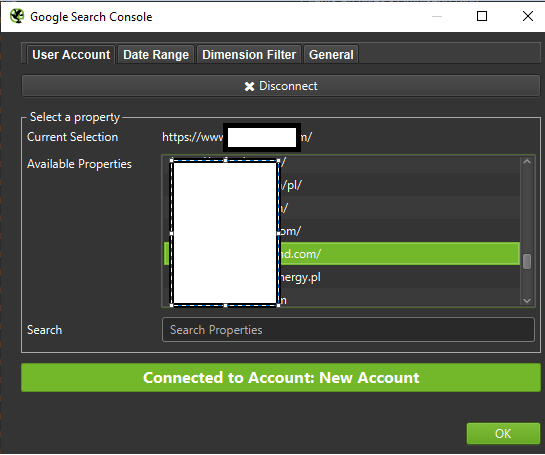

Dôležité: Odporúčam tiež využiť možnosť, ktorú poskytuje Screaming Frog, a nakŕmiť váš crawler údajmi z GA a Google Search Console. Táto integrácia predstavuje rýchly spôsob, ako identifikovať plytvanie rozpočtom na prehľadávanie, napríklad značný počet potenciálne nadbytočných adries URL, ktoré nemajú žiadnu návštevnosť.

Nástroje na analýzu denníka (Screaming Frog Logfile a iné)

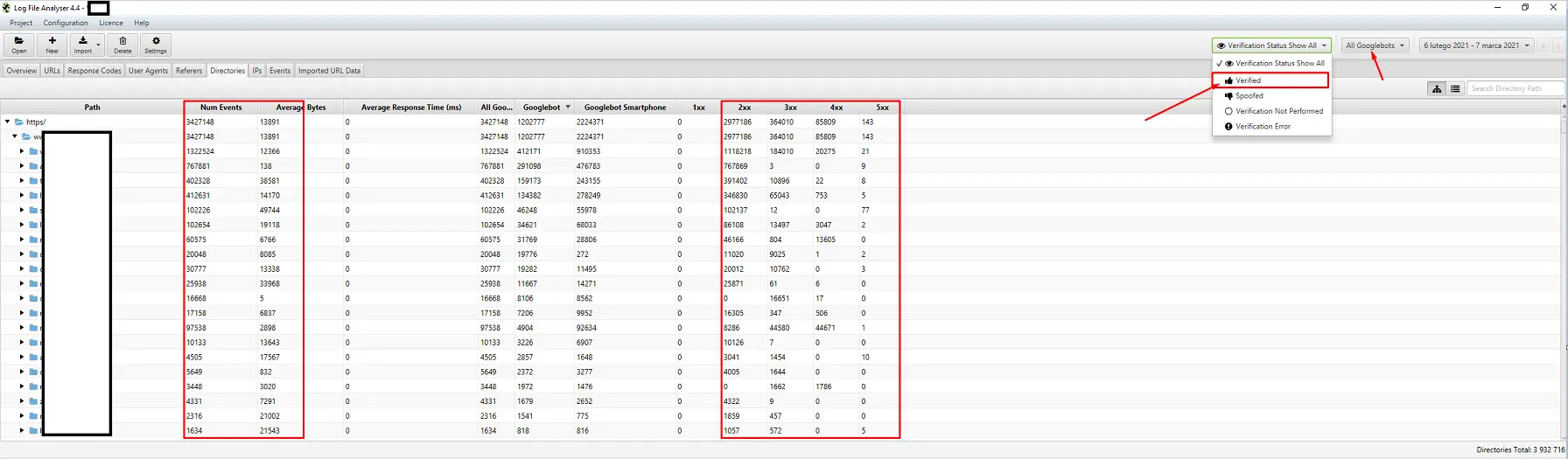

Výber analyzátora denníkov servera je vecou osobných preferencií. Mojím obľúbeným nástrojom je Screaming Frog Log File Analyzer. Možno to nie je najefektívnejšie riešenie (načítanie obrovského balíka protokolov = zavesenie aplikácie), ale páči sa mi jeho rozhranie. Dôležité je prikázať systému, aby zobrazoval len overené roboty Google.

Nástroje na sledovanie viditeľnosti

Užitočná pomôcka, pretože vám umožnia identifikovať vaše najlepšie stránky. Ak sa stránka umiestňuje vysoko v rebríčku Google na mnoho kľúčových slov (= má veľkú návštevnosť), môže mať potenciálne väčší dopyt po prehľadávaní (skontrolujte to v protokoloch – naozaj Google generuje viac návštev pre túto konkrétnu stránku?)

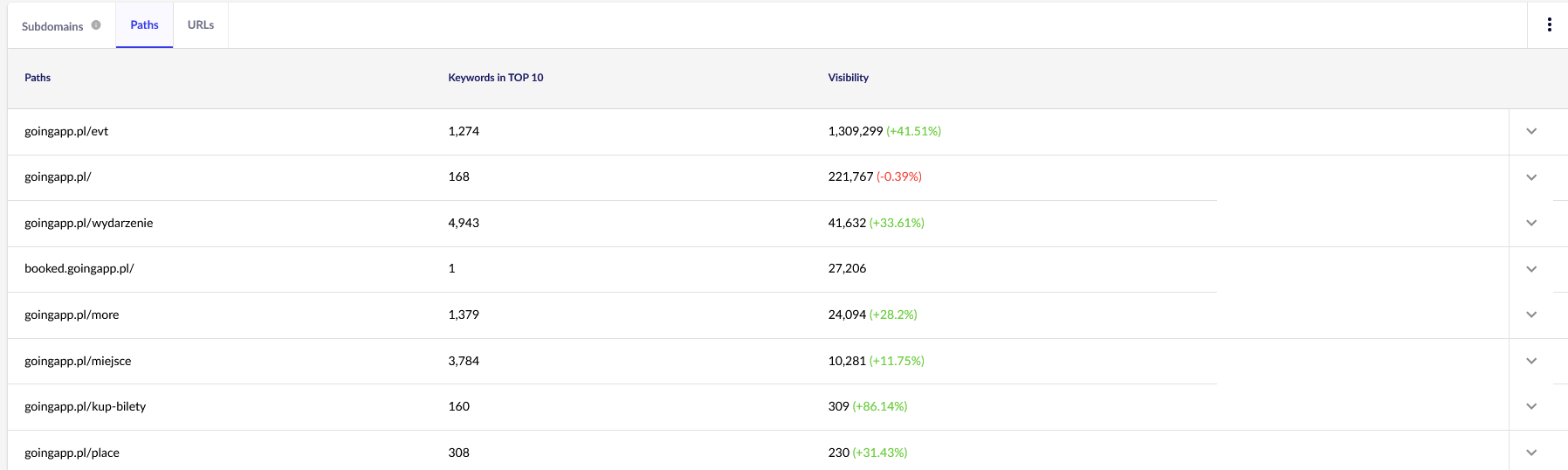

Pre naše účely budeme v budúcnosti potrebovať všeobecné prehľady v programe Senuto – Cesty a adresy URL – na ďalšie preskúmanie. Obe zostavy sú k dispozícii v časti Analýza viditeľnosti, záložka Sekcie. Pozrite si ich:

Naším hlavným bodom záujmu je druhá správa. Zoradíme ho tak, aby sme sa pozreli na viditeľnosť našich kľúčových slov (zoznam a celkový počet kľúčových slov, na ktoré sa naša webová stránka umiestňuje v TOP 10). Výsledky nám poslúžia na určenie hlavnej osi pre stimuláciu (a efektívne pridelenie) nášho rozpočtu na prehľadávanie.

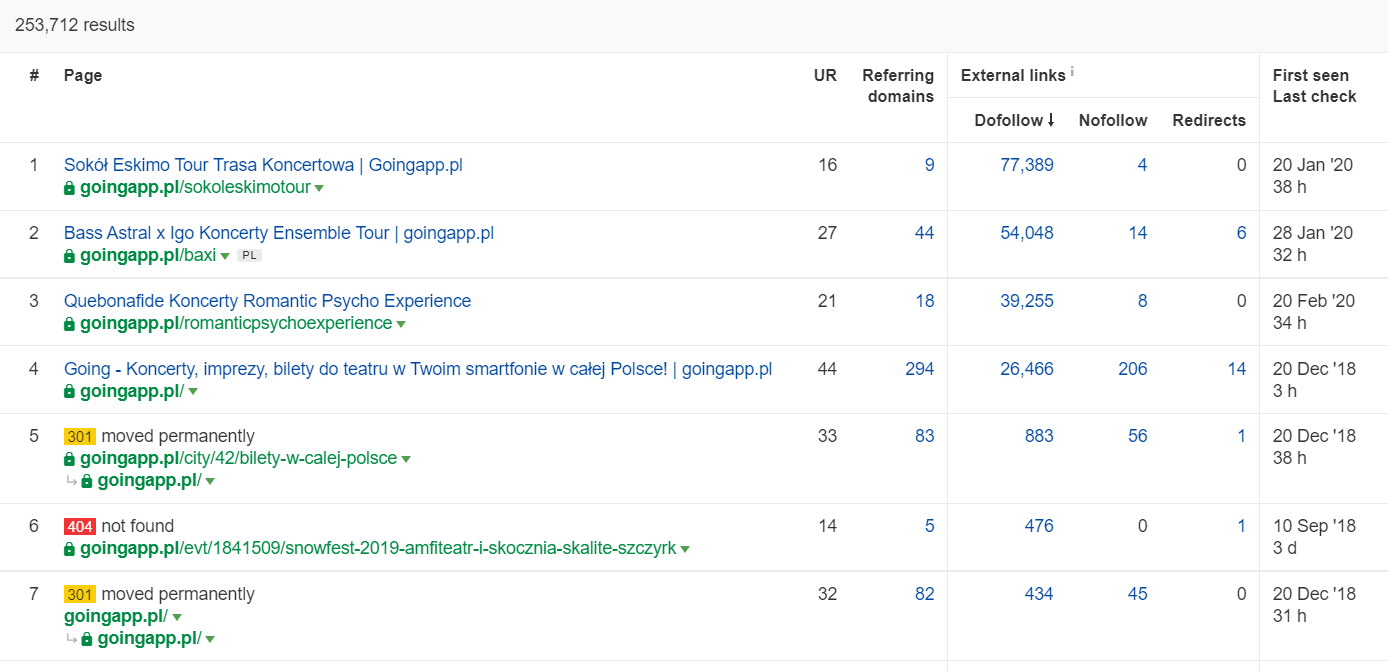

Nástroje na analýzu spätných odkazov (Ahrefs, Majestic)

Ak má niektorá z vašich stránok vysoké množstvo prichádzajúcich odkazov, použite ju ako pilier stratégie optimalizácie rozpočtu na prehľadávanie. Obľúbené stránky môžu prevziať úlohu rozbočovačov, ktoré prenášajú šťavu ďalej. Okrem toho má populárna stránka so slušným fondom hodnotných odkazov väčšiu šancu prilákať časté prehľadávanie.

V službe Ahrefs potrebujeme prehľad Stránky, a ak chceme byť presní, jeho časť s názvom: „Najlepšie podľa odkazov“:

Uvedený príklad ukazuje, že niektoré LP súvisiace s koncertmi naďalej generovali solídne štatistiky spätných odkazov. Aj napriek tomu, že všetky koncerty boli kvôli pandémii zrušené, stále sa oplatí používať historicky silné stránky, ktoré vzbudia zvedavosť prehľadávacích robotov a rozšíria šťavu do hlbších zákutí vášho webu.

Aké sú výpovedné znaky problému s rozpočtom na prehľadávanie?“

Zistenie, že máte do činenia s problematickým (príliš nízkym) rozpočtom na prehľadávanie, neprichádza ľahko. Prečo? Predovšetkým preto, že SEO je mimoriadne komplexný podnik. Nízke pozície alebo problémy s indexáciou môžu byť rovnako dobre dôsledkom priemerného profilu odkazov alebo nedostatku správneho obsahu na webovej lokalite.

Diagnostika rozpočtu na prehľadávanie zvyčajne zahŕňa kontrolu:

- .

- Aký čas uplynie od zverejnenia po indexáciu nových stránok (blogových príspevkov / produktov) za predpokladu, že nepožiadate o indexáciu prostredníctvom služby Google Search Console?

- Ako dlho spoločnosť Google uchováva neplatné adresy URL vo svojom indexe? Dôležité: presmerované adresy sú výnimkou – Google ich ukladá zámerne.

- Máte stránky, ktoré sa dostanú do indexu, aby z neho neskôr vypadli?

- Koľko času strávi Google na stránkach, ktoré negenerujú hodnotu (návštevnosť)? Prejdite na analýzu protokolov a zistite to.

Ako analyzovať a optimalizovať rozpočet prechádzania?“

Rozhodnutie vrhnúť sa do optimalizácie rozpočtu crawl je dané najmä veľkosťou vašej webovej stránky. Spoločnosť Google vo všeobecnosti naznačuje, že webové stránky s menej ako 1 000 strán by sa nemali trápiť nad maximálnym využitím dostupných limitov na prehľadávanie. Podľa mňa by ste mali začať bojovať o efektívnejšie a účinnejšie prehľadávanie, ak vaša webová lokalita obsahuje viac ako 300 stránok a váš obsah sa dynamicky mení (napríklad neustále pridávate nové stránky/písomky na blog).

Prečo? Je to otázka hygieny SEO. Zavedenie dobrých optimalizačných návykov a rozumné riadenie rozpočtu na prehľadávanie v začiatkoch vám v budúcnosti prinesie menej nápravy a redizajnu.

Optimalizácia rozpočtu prehľadávania. Štandardný postup

Vo všeobecnosti sa práca na analýze a optimalizácii rozpočtu craw skladá z troch fáz:

- .

- Zber údajov, čo je proces zhromažďovania všetkého, čo vieme o webovej lokalite – od webmasterov aj externých nástrojov.

- Analýza viditeľnosti a identifikácia nízko visiacich plodov. Čo beží ako hodinky? Čo by mohlo byť lepšie? Ktoré oblasti majú najväčší potenciál rastu?

- Odporúčania pre plazivý rozpočet.

Zber údajov pre audit crawl budgetu

1. Úplné prehľadávanie webových stránok vykonané pomocou niektorého z komerčne dostupných nástrojov. Cieľom je vykonať minimálne dve prehľadávania: prvé simuluje Googlebot, zatiaľ čo druhé načíta webovú lokalitu ako predvolený používateľský agent (postačí používateľský agent prehliadača). V tejto fáze vás zaujíma iba stiahnutie 100 % obsahu. Ak si všimnete, že sa prehľadávač dostal do slučky (keď po dni prehľadávania máme na pevnom disku stále len 10 % webovej lokality) – dajte najavo, že nastal problém a môžete prehľadávanie zastaviť. Rozumný počet adries URL na analýzu je v prípade veľkých webových lokalít približne 250-300 tisíc stránok.

a) To, čo hľadáme, sú najmä interné presmerovania 301, chyby 404, ale aj situácie, keď vaše texty môžu byť kategorizované ako tenký obsah. Screaming Frog má možnosť odhaliť takmer duplicitný obsah:

2. Denníky servera. Ideálny časový rámec by mal zahŕňať posledný mesiac, v prípade veľkých webových stránok však môžu stačiť dva posledné týždne. V najlepšom prípade by sme mali mať prístup k historickým protokolom servera, aby sme mohli porovnať pohyby Googlebot v čase, keď všetko prebiehalo hladko.

3. Export údajov z konzoly vyhľadávania Google. V kombinácii s bodmi 1 a 2 vyššie by vám údaje z Index Coverage a Crawl Stats mali poskytnúť pomerne komplexný prehľad o všetkom dianí na vašej webovej lokalite.

4. Údaje o organickej návštevnosti. Najlepšie stránky podľa údajov z Google Search Console, Google Analytics, ako aj Senuto a Ahrefs. Chceme identifikovať všetky stránky, ktoré vyčnievajú z davu svojimi štatistikami vysokej viditeľnosti, objemu návštevnosti alebo počtu spätných odkazov. Tieto stránky by sa mali stať základom vašej práce na rozpočte na prehľadávanie. Použijeme ich na zlepšenie prehľadávania najdôležitejších stránok.

5. Manuálne preskúmanie indexu. V niektorých prípadoch je najlepším priateľom odborníka na SEO jednoduché riešenie. V tomto prípade: preskúmanie údajov prevzatých priamo z indexu! Je to dobrá výzva na kontrolu vašej webovej stránky pomocou kombinácie operátorov inurl: + site:.

Nakoniec musíme všetky získané údaje zlúčiť. Zvyčajne použijeme externý crawler s funkciami umožňujúcimi import externých údajov (údaje GSC, logy servera a údaje o organickej návštevnosti).

Analýza viditeľnosti a nízko visiace ovocie

Tento proces si zaslúži samostatný článok, ale naším dnešným cieľom je získať pohľad na naše ciele pre webové stránky a dosiahnutý pokrok z vtáčej perspektívy. Zaujíma nás všetko, čo sa vymyká bežným zvyklostiam: náhle poklesy návštevnosti (ktoré sa nedajú vysvetliť sezónnymi trendmi) a súčasné posuny v organickej viditeľnosti. Zisťujeme, ktoré skupiny stránok sú najsilnejšie, pretože sa stanú našimi HUBAMI na zatlačenie Googlebota hlbšie do našej webovej lokality.

V dokonalom svete by takáto kontrola mala pokrývať celú históriu našej webovej stránky od jej spustenia. Keďže však objem údajov každý mesiac neustále narastá, zamerajme sa na analýzu viditeľnosti a organickej návštevnosti z obdobia posledných 12 mesiacov.

Prehľadávanie rozpočtu – naše odporúčania

Uvedené činnosti sa budú líšiť v závislosti od veľkosti optimalizovanej webovej lokality. Sú to však najdôležitejšie prvky, ktoré vždy zohľadňujem pri vykonávaní analýzy rozpočtu crawl. Prevažujúcim cieľom je odstrániť úzke miesta na vašej webovej lokalite. Inými slovami, zaručiť maximálnu prehľadateľnosť pre roboty Google (alebo iné indexovacie agenty).

1. Začnime od základov – odstránenie všetkých druhov chýb 404/410, analýza interných presmerovaní a ich odstránenie z interného prepojenia. Našu prácu by sme mali ukončiť záverečným prehľadávaním. Tentoraz by všetky odkazy mali vracať kód odpovede 200, bez interných presmerovaní a chýb 404.

- V tejto fáze je dobré opraviť všetky reťazce presmerovaní zistené v správe o spätných odkazoch.

2. Po prehľadávaní sa uistite, že štruktúra našej webovej stránky neobsahuje do očí bijúce duplicity.

- Kontrolujte aj proti potenciálnej kanibalizácii – okrem problémov vyplývajúcich z cielenia na rovnaké kľúčové slovo s viacerými stránkami (skrátka prestávate kontrolovať, ktorú stránku Google zobrazí), kanibalizácia negatívne ovplyvňuje celý váš rozpočet na prehľadávanie.

- Zjednoťte identifikované duplikáty do jednej adresy URL (zvyčajne tej, ktorá má vyššie hodnotenie)

.

3. Skontrolujte, koľko adries URL má značku noindex. Ako vieme, Google môže tieto stránky stále prechádzať. Len sa nezobrazujú vo výsledkoch vyhľadávania. Snažíme sa minimalizovať podiel značiek noindex v štruktúre našich webových stránok.

- .

- Príklad – blog organizuje svoju štruktúru pomocou značiek; autori tvrdia, že toto riešenie je diktované pohodlím používateľa. Každý príspevok je označený 3 až 5 značkami, ktoré sú priradené nekonzistentne a nie sú indexované. Analýza protokolov ukazuje, že je to tretia najprechádzanejšia štruktúra na webovej lokalite.

4. Preskúmajte súbor robots.txt. Nezabudnite, že implementácia súboru robots.txt neznamená, že spoločnosť Google nezobrazí adresu v indexe.

- .

- Preskúmajte, ktoré zo zablokovaných štruktúr adries sa stále prehľadávajú. Možno ich odrezanie spôsobuje úzke miesto?

- Odstráňte zastarané/nepotrebné smernice.

5. Analyzujte objem nekanonických adries URL na vašej webovej lokalite. Google prestal považovať rel=“canonical“ za tvrdú smernicu. V mnohých prípadoch vyhľadávač tento atribút vyslovene ignoruje (parametre triedenia v indexe – stále nočná mora).

6. Analyzujte filtre a ich základný mechanizmus. Filtrovanie výpisov je najväčšou bolesťou hlavy pri optimalizácii rozpočtu na prehľadávanie. Majitelia podnikov elektronického obchodu trvajú na implementácii filtrov použiteľných v akejkoľvek kombinácii (napríklad filtrovanie podľa farby + materiálu + veľkosti + dostupnosti… do omrzenia). Toto riešenie nie je optimálne a malo by sa obmedziť na minimum.

7. Architektúra informácií na webovej lokalite – taká, ktorá zohľadňuje obchodné ciele, potenciál návštevnosti a aktuálny profil odkazov. Pracujme s predpokladom, že odkaz na obsah rozhodujúci pre naše obchodné ciele by mal byť viditeľný na celom webe (na všetkých stránkach) alebo na domovskej stránke. Samozrejme, zjednodušujeme tu, ale domovská stránka a horné menu / odkazy na celom webe sú najsilnejšími ukazovateľmi pri budovaní hodnoty z interného prepojenia. Zároveň sa snažíme dosiahnuť optimálne rozloženie domény: naším cieľom je situácia, keď môžeme začať prehľadávanie z ľubovoľnej stránky a stále dosiahneme rovnaký počet stránok (každá adresa URL by mala mať minimálne jeden prichádzajúci odkaz).

- Práca na robustnej informačnej architektúre je jedným z kľúčových prvkov optimalizácie rozpočtu na prehľadávanie. Umožňuje nám uvoľniť časť zdrojov bota z jedného miesta a presmerovať ich na iné. Je to zároveň jedna z najväčších výziev, pretože si vyžaduje spoluprácu zainteresovaných strán z biznisu – čo často vedie k obrovským bitkám a kritike podkopávajúcej odporúčania SEO.

8. Vykresľovanie obsahu. Kritické v prípade webových stránok, ktorých cieľom je založiť svoje vnútorné prepojenie na odporúčacích systémoch zachytávajúcich správanie používateľov. Predovšetkým väčšina týchto nástrojov sa spolieha na súbory cookie. Spoločnosť Google neukladá súbory cookie, takže nezískava prispôsobené výsledky. Výsledok: Google vidí vždy rovnaký obsah alebo žiadny obsah.

- Častou chybou je, že bránime Googlebotovi v prístupe ku kritickému obsahu JS/CSS. Tento krok môže viesť k problémom s indexovaním stránky (a k plytvaniu času spoločnosti Google na vykresľovanie nedostupného obsahu).

9. Výkonnosť webových stránok – základné webové vitálne údaje. Aj keď som skeptický, pokiaľ ide o vplyv CWV na umiestnenie stránok (z mnohých dôvodov vrátane rôznorodosti komerčne dostupných zariadení a rôznej rýchlosti internetového pripojenia), je to jeden z parametrov, ktorý sa najviac oplatí prediskutovať s kóderom.

10. Sitemap.xml – skontrolujte, či funguje a obsahuje všetky kľúčové prvky (nič okrem kanonických adries URL, ktoré vracajú stavový kód 200).

- .

- Mojím prvým odporúčaním pre optimalizáciu sitemap.xml je rozdeliť stránky podľa typu alebo – ak je to možné – podľa kategórie. Rozdelenie vám poskytne plnú kontrolu nad pohybom a indexáciou obsahu spoločnosťou Google.

Łukasz Rogala

Łukasz Rogala